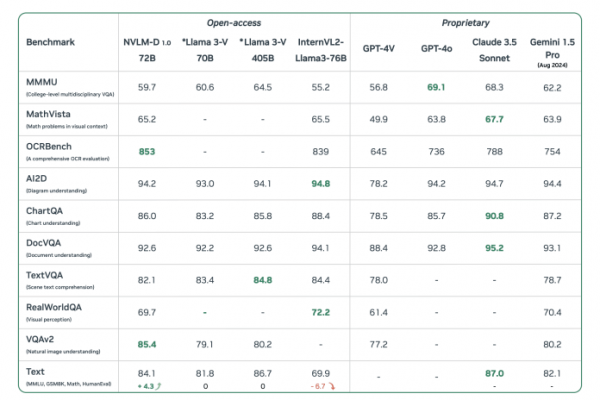

NVLM 1.0 (языковая модель NVIDIA Vision) – это семейство открытых мультимодальных LLM, состоящее из моделей NVLM-D (модель только для декодера), NVLM-X (модель X-внимания) и NVLM-H (гибридная модель) на 34 В и 72 В. Модели особенно хорошо справляются с визуальными задачами. Например, в тесте OCRBench, проверяющем способность моделей читать текст с изображений, NVLM-D превосходит даже GPT-4o– новейшая мультимодальная модель OpenAI. Модель также понимает мемы, понимает человеческий почерк и хорошо отвечает на вопросы, чувствительные к точному местоположению чего-либо на изображении.

В математических вопросах модель также превосходна: она превосходит LLM от Google и отстает от флагманской модели Claude 3.5 всего на 3 балла. от известного стартапа Anthropic. В таблице ниже показаны все опубликованные тесты, показывающие, насколько высоко продвинулась Nvidia по сравнению с другими открытыми моделями (даже более крупными).

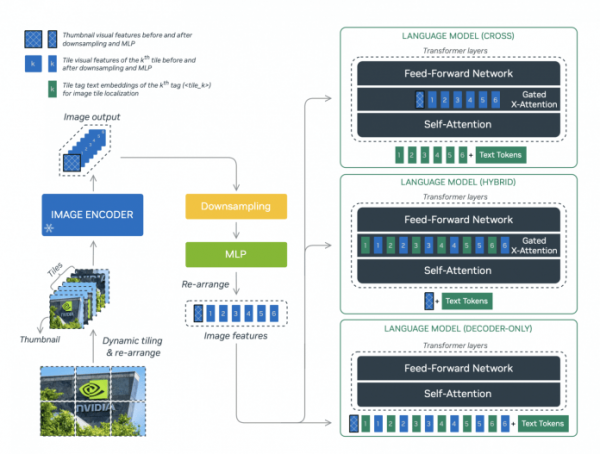

Три разные модели семейство имеет схожую архитектуру, но имеет разные функции и, в частности, по-разному обрабатывает изображения. NVLM-D использует предварительно обученный кодер изображений, подключенный к обычному двухслойному перцептрону. NVLM-X использует механизм перекрестного внимания при обработке токенов изображений. Каждый подход имеет недостатки и преимущества. Например, NVLM-D более экономичен по количеству параметров, но потребляет больше мощности графического процессора и хуже обрабатывает изображения высокого разрешения, чем NVLM-X. Таким образом, модель NVLM-H стала чем-то средним между эффективным и быстрым NVLM-D и точным NVLM-X.